Abstract

In questo articolo si discute il ruolo della memoria e dell’oblio nella costruzione dell’identità personale e sociale, confrontando l’era pre-digitale con l’attuale epoca digitale. Nell’era pre-digitale, la diffusione delle informazioni era limitata e controllata principalmente dai media tradizionali. Tuttavia, l’avvento di Internet ha radicalmente cambiato questa situazione, consentendo un’ampia diffusione e accessibilità delle informazioni, con la possibilità di conservare il passato in un “quasi eterno presente”. Questo aumento esponenziale delle informazioni online presenta rischi per l’individuo, come la perdita della dimensione cronologica delle notizie e il potenziale deterioramento dell’immagine personale a causa dell’accesso alle informazioni passate. Viene, inoltre, proposto il “diritto all’oblio” come uno strumento di tutela per impedire che eventi passati influenzino negativamente l’immagine attuale di una persona. L’attenzione viene posta, altresì, all’evolversi del concetto di oblio nel tempo, l’impatto della transizione al mondo digitale su questo diritto e le norme europee, in particolare il Regolamento UE 2016/676, che riguardano la protezione dei dati personali e contribuiscono alla definizione del diritto all’oblio.

Premessa

Il dibattito sulla regolamentazione di Internet e sul suo impatto sulla libertà di espressione e sulla privacy individuale è un argomento complesso e sfaccettato. L’avanzamento tecnologico nell’ambito delle Tecnologie dell’Informazione e della Comunicazione (ICT) ha portato a una rivoluzione nelle modalità di comunicazione e nell’esercizio dei diritti fondamentali, in particolare la libertà di espressione, garantita dalla Costituzione all’articolo 21. Questa trasformazione ha sollevato questioni importanti riguardo alla privacy e alla protezione dei dati personali, culminando nel concetto di “diritto all’oblio”, che permette alle persone di richiedere la rimozione di informazioni obsolete o irrilevanti su di loro da Internet.

Le sfide legislative nel bilanciare i diritti alla libertà di informazione e alla privacy sono notevoli, in particolare in un contesto globalizzato dove la diffusione delle informazioni è praticamente illimitata. Il tentativo di regolamentare Internet ha spesso suscitato controversie, percepite da alcuni come tentativi di limitare la libertà di espressione. Tuttavia, la mancanza di regolamentazione adeguata può portare a un’atmosfera di anarchia online, dove la responsabilità personale è facilmente elusa.

La decisione del CERN di rendere pubblica la tecnologia del World Wide Web nel 1993, ha segnato l’inizio di una nuova era di accessibilità all’informazione, ma ha anche introdotto il dilemma di come gestire una rete globale senza regole chiare. Questo ha portato all’emergere di “nuovi diritti” legati alla digitalizzazione della società, tra cui il diritto alla riservatezza e il diritto all’oblio, interpretati come estensioni dei diritti costituzionali esistenti. Questi diritti mirano a proteggere la dignità e la privacy degli individui nell’era digitale, consentendo loro di controllare come le loro informazioni personali vengono condivise e ricordate online.

In conclusione, la necessità di proteggere l’identità digitale delle persone e di garantire la loro privacy online è diventata una priorità nell’attuale società dell’informazione. Il diritto all’oblio emerge come uno strumento fondamentale per salvaguardare la reputazione e l’identità personale degli individui, affrontando le sfide poste dalla permanenza e dalla pervasività delle informazioni personali su Internet.

L’ implementazione del diritto all’oblio presenta sfide significative che richiedono un equilibrio attento tra la privacy individuale e la libertà di informazione. In un mondo sempre più interconnesso e digitale, il diritto all’oblio continua a essere un argomento di grande rilevanza e dibattito.

Tutela della riservatezza: il diritto all’oblio. Il quadro normativo italo-europeo

Nel panorama giuridico europeo, la protezione dei dati personali si è affermata come un diritto fondamentale, rispondendo alla necessità di bilanciare la privacy individuale con le libertà di informazione ed espressione in un contesto sempre più dominato dalla presenza digitale. La distinzione tra il diritto alla protezione dei dati personali e il diritto al rispetto della vita privata, come delineato nella Carta dei diritti fondamentali dell’Unione europea, segnala un’evoluzione da una concezione statica e negativa della privacy verso una tutela dinamica e proattiva dei dati, implicando un potere di intervento e controllo non solo da parte degli individui ma anche attraverso la supervisione di autorità indipendenti.

Questo cambiamento trova conferma nell’evoluzione legislativa, partendo dalla direttiva 95/46/CE, attraverso l’introduzione del Codice in materia di protezione dei dati personali in Italia (d.lgs. 196/2003), fino all’adozione del Regolamento (UE) 2016/679 (GDPR – General Data Protection Regulation), che ha introdotto un quadro giuridico uniforme e direttamente applicabile in tutti gli Stati membri dell’Unione Europea. L’intento è quello di assicurare che il trattamento dei dati personali avvenga nel rispetto dei diritti e delle libertà fondamentali degli individui.

Tuttavia, il dibattito sul diritto all’oblio, specialmente in relazione al ruolo dei motori di ricerca e alla gestione delle informazioni online, ha sollevato questioni complesse sul bilanciamento dei diritti in gioco. La sentenza della Corte di Giustizia dell’Unione Europea nel caso Google Spain ha segnato un punto di svolta, riconoscendo la responsabilità dei motori di ricerca nel trattamento dei dati personali e affermando il diritto degli individui di richiedere la rimozione di informazioni obsolete o irrilevanti dalla lista dei risultati di ricerca, ponendo le basi per una tutela più efficace della privacy digitale.

In contrapposizione, la Corte Europea dei Diritti dell’Uomo ha adottato un approccio differente, privilegiando la libertà di espressione e il diritto del pubblico all’informazione rispetto al diritto all’oblio, suggerendo una soluzione meno drastica attraverso l’aggiunta di precisazioni o aggiornamenti alle informazioni già pubblicate, piuttosto che la loro rimozione completa.

Queste dinamiche riflettono le tensioni intrinseche nel bilanciamento tra privacy e trasparenza nell’era digitale, evidenziando l’importanza di un dialogo continuo e di un approccio multilivello alla regolamentazione dei diritti in rete, che tenga conto della complessità e della fluidità del contesto digitale globale. La sfida per legislatori e giudici rimane quella di trovare equilibri dinamici che possano tutelare efficacemente i diritti degli individui senza soffocare le libertà fondamentali che sono alla base di una società democratica e informata.

Il “diritto all’oblio”, inteso come la prerogativa di essere dimenticati dalla collettività, si afferma nel contesto giuridico come una dimensione fondamentale della tutela della privacy e dell’identità personale nell’era digitale. Questo diritto consente agli individui di richiedere la deindicizzazione e, in alcuni casi, la cancellazione di dati personali dai motori di ricerca quando tali informazioni, un tempo pertinenti o di interesse pubblico, diventano obsolete o irrilevanti, evitando così una perpetua esposizione mediatica che potrebbe danneggiare la reputazione personale.

Viene in tal modo introdotta la possibilità per ogni individuo di richiedere la cancellazione di informazioni che, con il trascorrere del tempo, hanno perso rilevanza o interesse pubblico. L’attuazione di tale diritto si basa sulla valutazione della persistente rilevanza delle informazioni, tenendo conto dell’evoluzione del contesto sociale e informativo.

La giurisprudenza civile stabilisce criteri specifici per la pubblicazione di notizie che potrebbero compromettere l’onore e la reputazione, richiedendo la verità oggettiva della notizia, l’interesse pubblico alla conoscenza del fatto e la correttezza formale dell’esposizione. Con il tempo, è emersa una nuova sensibilità giuridica che limita il diritto di cronaca alla luce dell’attualità delle notizie, precludendo la diffusione di informazioni non più rilevanti socialmente o d’interesse pubblico.

Il diritto all’oblio si distingue per la sua funzione di tutela dell’identità personale di fronte all’impatto potenzialmente illimitato e duraturo delle informazioni digitali. La giurisprudenza civile enfatizza la necessità di proteggere la proiezione sociale dell’identità dell’individuo, assicurando che dati personali obsoleti o non più pertinenti non siano ulteriormente diffusi, in considerazione dell’evoluzione della reputazione e dell’identità personale nel tempo.

Questa concezione del diritto all’oblio viene riconosciuta anche dalla Corte Costituzionale, che ha stabilito la possibilità di cancellare dal casellario giudiziale le iscrizioni di responsabili di illeciti minori dopo un periodo adeguato senza ulteriori reati, riaffermando l’importanza del bilanciamento tra il diritto all’oblio e altre esigenze di carattere pubblico.

La Suprema Corte ribadisce che il diritto all’oblio non si riduce alla mera cancellazione di notizie dannose per la reputazione, ma implica la capacità di aggiornare o rimuovere informazioni che, con il passare del tempo, diventano lesive per l’identità personale dell’interessato. Questo diritto si estende alla protezione contro la diffusione non necessaria di notizie passate che non presentano più un interesse pubblico o una rilevanza sociale, stabilendo un equilibrio tra il diritto di cronaca e la libertà di espressione, da un lato, e la tutela della privacy e dell’identità personale, dall’altro.

L’approfondimento mira a delineare come questi diritti contribuiscano a consolidare il principio di autodeterminazione informativa, permettendo all’individuo un controllo più stringente sulle proprie informazioni personali.

Il diritto alla cancellazione, articolato nell’articolo 17 del GDPR, offre all’interessato la facoltà di richiedere la rimozione dei dati personali che lo riguardano, sotto specifiche condizioni. Queste includono scenari in cui i dati non sono più necessari rispetto alle finalità per le quali sono stati raccolti, il ritiro del consenso su cui si basa il trattamento, o il rilevamento di trattamento illecito dei dati. La normativa chiarisce che tale diritto non è assoluto ma condizionato dalla presenza di determinate circostanze che legittimano la richiesta di cancellazione, al fine di bilanciare altri interessi fondamentali, come la libertà di espressione e il diritto all’informazione. La cancellazione dei dati non può avvenire automaticamente se prevale un interesse pubblico legittimo o se i dati sono necessari per l’accertamento, l’esercizio o la difesa di un diritto in sede giudiziaria.

Oltre alla distruzione fisica dei dati, il regolamento contempla alternative quali l’anonimizzazione, intendendo qualsiasi processo che renda i dati non riconducibili all’identità del soggetto interessato. Tale approccio differisce dalla pseudonimizzazione, in quanto quest’ultima non preclude la possibilità di futura reidentificazione. Pertanto, l’efficacia del diritto alla cancellazione si manifesta attraverso la irreversibilità della separazione tra i dati e l’identità dell’individuo, un aspetto fondamentale per la tutela della privacy. La normativa impone al titolare del trattamento di valutare le richieste di cancellazione nel rispetto del principio di proporzionalità, tenendo conto dei costi, delle tecnologie disponibili e della propria organizzazione. Qualora i dati oggetto della richiesta di cancellazione siano stati condivisi con terzi, il titolare è tenuto a informare tali entità della necessità di adottare misure analoghe a quelle intraprese direttamente.

Nel complesso giurisprudenziale e normativo vanno ricordate:

- Sentenza della Corte (Grande Sezione) del 13 maggio 2014. Google Spain SL e Google Inc. contro Agencia Española de Protección de Datos (AEPD) e Mario Costeja González. Causa C131/12. “Il gestore di un motore di ricerca su Internet è responsabile del trattamento da esso effettuato dei dati personali che appaiono su pagine web pubblicate da terzi. Così, nel caso in cui, a seguito di una ricerca effettuata a partire dal nome di una persona, l’elenco di risultati mostra un link verso una pagina web che contiene informazioni sulla persona in questione, questa può rivolgersi direttamente al gestore oppure, qualora questi non dia seguito alla sua domanda, adire le autorità competenti per ottenere, in presenza di determinate.” La Corte di Giustizia dell’Unione Europea nel caso Google Spain ha posto le basi per il riconoscimento del diritto all’oblio nel contesto dei motori di ricerca. La Corte ha stabilito che i motori di ricerca hanno la responsabilità di rimuovere i link a informazioni obsolete o non più rilevanti, equilibrando il diritto alla privacy degli individui con il diritto del pubblico all’accesso alle informazioni. Questa decisione ha evidenziato il ruolo dei motori di ricerca nella gestione delle informazioni personali e ha sottolineato la necessità di valutare attentamente le richieste di deindicizzazione in base all’interesse pubblico e alla rilevanza delle informazioni.

- Sentenza della Corte di giustizia nella causa C-136/17 (24 settembre 2019)

GC e a./Commission nationale de l’informatique et des libertés (CNIL). “Il divieto di trattare determinate categorie di dati personali sensibili si applica anche ai gestori di motori di ricerca. Nell’ambito di una domanda di deindicizzazione, dev’essere effettuato un bilanciamento tra i diritti fondamentali del richiedente la deindicizzazione e quelli degli utenti di Internet potenzialmente interessati a tali informazioni”.

- Sentenza nella causa C-507/17 (24 settembre 2019). Google LLC, succeduta alla Google Inc./ Commission nationale de l’informatique et des libertés (CNIL)“Il gestore di un motore di ricerca non è tenuto a effettuare la deindicizzazione in tutte le versioni del suo motore di ricerca. È tuttavia tenuto ad effettuarla nelle versioni di tale motore di ricerca corrispondenti a tutti gli Stati membri e ad attuare misure che scoraggino gli utenti di Internet dall’avere accesso, a partire da uno degli Stati membri, ai link di cui trattasi contenuti nelle versioni extra UE di detto motore”.

- La sentenza della Corte di giustizia dell’Unione Europea nella causa C-460/20, relativa al caso Google (Deindicizzazione di contenuti asseritamente inesatti), rappresenta un importante punto di riferimento nell’ambito del diritto alla protezione dei dati personali, in particolare per quanto concerne il “diritto all’oblio”). Il contesto della sentenza riguarda la richiesta da parte di due dirigenti di un gruppo di società di investimenti affinché Google deindicizzasse risultati di ricerca collegati a loro nomi, i quali contenevano link verso articoli criticando il loro modello di investimento con affermazioni ritenute inesatte, e l’eliminazione delle loro fotografie sotto forma di miniature da risultati di ricerca di immagini. La Corte di giustizia sottolinea che il diritto alla protezione dei dati personali non è assoluto ma deve essere bilanciato con altri diritti fondamentali, come la libertà di informazione, seguendo il principio di proporzionalità. La normativa europea prevede eccezioni al diritto alla cancellazione quando il trattamento dei dati è necessario per l’esercizio del diritto alla libertà di informazione. Nella sua decisione, la Corte stabilisce che i diritti alla protezione della vita privata e dei dati personali prevalgono generalmente sull’interesse degli utenti di Internet all’accesso alle informazioni, ma questo equilibrio può variare a seconda delle circostanze del caso, incluse la natura e la sensibilità delle informazioni e l’interesse pubblico ad esse associato. Tuttavia, quando le informazioni indicizzate si rivelano manifestamente inesatte, o almeno una parte di esse di non minore importanza, il diritto alla libertà d’espressione e di informazione non può essere considerato per giustificare il loro mantenimento nell’indice del motore di ricerca. Per quanto riguarda l’obbligo di prova in capo a chi richiede la deindicizzazione, la Corte precisa che spetta a questa persona dimostrare l’inesattezza manifesta delle informazioni, fornendo prove ragionevolmente ricercabili, senza che ciò comporti un onere eccessivo. Non è necessario, almeno nella fase precontenziosa, fornire una decisione giudiziaria contro l’editore del sito. Il gestore del motore di ricerca, ricevuta una richiesta di deindicizzazione supportata da elementi di prova pertinenti e sufficienti, è tenuto ad accoglierla, soprattutto se esiste una decisione giudiziaria che attesta l’inesattezza delle informazioni. In assenza di manifesta inesattezza evidente dagli elementi forniti, e senza una decisione giudiziaria che lo confermi, il gestore del motore di ricerca non è obbligato ad accogliere la richiesta, ma il richiedente può rivolgersi alle autorità competenti per ulteriori verifiche. Questa sentenza impone ai gestori dei motori di ricerca di adottare un approccio più attento e ponderato nell’esaminare le richieste di deindicizzazione, tenendo conto dei diritti fondamentali coinvolti e delle prove fornite dai richiedenti.

- In particolare riferimento al nostro Paese, va evidenziato il d.lgs. 150 del 2022, noto come Riforma Cartabia, che ha introdotto nell’ordinamento giuridico italiano l’articolo 64-ter riguardante il “diritto all’oblio degli imputati e delle persone sottoposte a indagini” nelle disposizioni di attuazione del codice di procedura penale. Questa novità normativa mira a bilanciare il rapporto tra processo penale, media, e diritto all’oblio, fornendo strumenti legali per limitare la diffusione di informazioni che possano ledere la reputazione di individui già prosciolti o assolti. L’articolo 64-ter dispone che le persone a cui è stata pronunciata una sentenza di proscioglimento, non luogo a procedere, o un decreto di archiviazione, hanno il diritto di richiedere la deindicizzazione (rimozione da risultati di ricerca internet) o la preclusione dell’indicizzazione dei dati personali citati nei provvedimenti giudiziari. Questo è un passo avanti significativo nel riconoscere e tutelare il diritto all’oblio digitale di individui ingiustamente coinvolti in procedimenti penali, offrendo un rimedio legale contro la permanente disponibilità e accessibilità di informazioni potenzialmente dannose su internet. L’introduzione di questo articolo risponde all’esigenza di proteggere la dignità e la reputazione delle persone nell’era digitale, dove le informazioni su internet hanno una longevità e una diffusione senza precedenti. La normativa cerca di armonizzare le disposizioni italiane con i principi del diritto all’oblio sanciti a livello europeo, in particolare con il regolamento GDPR che prevede il diritto alla cancellazione dei dati personali. Nonostante l’innovazione legislativa, emergono alcune criticità nella sua applicazione pratica, come la definizione dei criteri per l’accoglimento delle richieste di deindicizzazione e la modalità con cui tali richieste sono esaminate e attuate dai motori di ricerca. Inoltre, vi sono dubbi sull’effettiva capacità della norma di assicurare una tutela efficace dell’oblio digitale, considerando le sfide tecniche e giuridiche legate alla gestione delle informazioni online e le implicazioni per la libertà di espressione e il diritto all’informazione. L’articolo 64-ter rappresenta un tentativo significativo di adeguare il diritto italiano alle sfide poste dalla digitalizzazione della società e dall’interazione tra privacy, reputazione online e diritti delle persone coinvolte in procedimenti giudiziari. Tuttavia, la sua efficacia pratica dipenderà dalla capacità di risolvere le questioni operative e interpretative che ne derivano, necessitando possibilmente di futuri aggiustamenti legislativi o interpretativi per garantire una protezione effettiva del diritto all’oblio.

L’Internet che non dimentica vs “right to be forgotten”

Nel contesto dell’era digitale, la questione dell’oblio e della memoria collettiva assume connotazioni inedite e complesse. La riflessione si apre con l’interrogativo su quale forma assuma la vita in un’epoca dove “Google ricorda sempre”, evidenziando i pericoli emergenti legati alla rete, un dominio che funge da deposito per un’implacabile memoria collettiva. La digitalizzazione ha portato a una situazione dove ogni aspetto della vita umana viene raccolto, cristallizzato e reso eternamente accessibile nell’ “inconscio digitale”, trasformando la memoria, un tempo intesa come un accumulo di esperienze, in un peso da cui liberarsi.

Il desiderio di oblio, quindi, non nasce tanto dalla volontà di eludere uno sguardo indesiderato, quanto dalla necessità di ritirarsi in una zona d’ombra digitale, dove le tracce personali possono essere “cancellate”. Questo bisogno si è intensificato con l’avvento di Internet e delle nuove tecnologie, che hanno reso ogni traccia della vita umana permanentemente accessibile, ponendo le basi per il diritto all’oblio. Questo diritto, emergente tra gli anni ‘80 e ‘90, oscilla tra il rispetto dell’identità della persona e il diritto alla riservatezza, assumendo una configurazione autonoma grazie all’espansione dei cosiddetti diritti della personalità.

L’evoluzione giuridica di tale diritto, è stato riconosciuto e definito attraverso un processo di reinterpretazione dell’art. 2 della Costituzione italiana, che considera la tutela della personalità umana in tutte le sue espressioni, anche quelle non ancora normativamente tipizzate. Questo approccio ha portato al riconoscimento giuridico di situazioni esistenziali quali il diritto alla riservatezza e il diritto all’identità personale, distinguendoli per la prima volta e ponendo le basi per l’emergere del diritto all’oblio.

Il diritto all’oblio, pertanto, è stato inizialmente inteso come la pretesa di non vedere rievocati fatti già resi di pubblico dominio, con l’obiettivo di proteggere l’individuo da una nuova notorietà indesiderata. La giurisprudenza di legittimità ha successivamente qualificato l’oblio come l’interesse a non restare indefinitamente esposto ai danni ulteriori arrecati alla reputazione dall’incessante pubblicazione di notizie passate.

Nel bilanciamento tra diritto all’oblio e diritto di cronaca, emerge la complessità di armonizzare l’interesse pubblico all’informazione con il diritto individuale alla dimenticanza. La prevalenza di uno sull’altro dipende dalla rilevanza attuale della notizia e dall’esistenza di un interesse pubblico nella sua rievocazione.

Nell’era della digitalizzazione, la nozione di privacy subisce una trasformazione radicale, evidenziando come la dimensione virtuale influenzi profondamente il concetto di spazio personale. È evidente come la rivoluzione elettronica e tecnologica abbia espanso lo schermo della vita personale oltre il personal computer, immergendola nell’intero spazio della rete. Questo cambio di paradigma solleva interrogativi significativi sulla possibile perdita di diritti in un contesto dove la privacy tradizionale, intesa come “diritto a essere lasciato solo”, non sembra più adeguata a tutelare l’individuo contro intrusioni non desiderate.

La trasformazione della “sfera privata” in un luogo di scambio e condivisione di dati personali richiede un’evoluzione verso la “protezione dei dati”, concetto elaborato nell’ambito europeo per rispondere alla necessità di una disciplina uniforme che regoli i nuovi spazi sconfinati e mobili della rete. Il contesto digitale, caratterizzato da un pluralismo di fonti e una molteplicità di giurisdizioni, presenta sfide significative nella risoluzione delle controversie e nel bilanciamento tra diritti personali e la libertà di informazione. La peculiarità dei diritti in rete, che non ammettono una gerarchizzazione a causa della natura intrinsecamente egualitaria della rete, richiede un approccio “multilevel” per la loro regolamentazione.

In questo scenario, il diritto all’oblio emerge come una necessità di governare la propria memoria digitale, offrendo a ciascuno la possibilità di reinventarsi e costruire una nuova identità personale, liberandosi dalle “gabbie” imposte da una memoria onnipresente e totalizzante. Tuttavia, la regolamentazione dei diritti in un dominio apparentemente anarchico come il web solleva interrogativi fondamentali sui meccanismi di governance, sul ruolo degli Stati e sulla capacità delle leggi di adattarsi a una realtà in continuo mutamento.

Il dibattito sulla regolamentazione del ciberspazio, evidenziato dalla Dichiarazione d’indipendenza del ciberspazio, mostra la tensione tra la necessità di tutelare i diritti umani in un contesto digitale e la resistenza a un controllo centralizzato. Le questioni su chi debba essere il legislatore e quale giudice debba applicare i diritti proclamati riflettono le sfide poste dalla nascita di nuovi diritti umani nell’era digitale, sottolineando l’urgenza di trovare soluzioni innovative per garantire la protezione della privacy e altri diritti fondamentali nell’ambito virtuale. La risposta a queste sfide passa attraverso un dialogo inclusivo tra diversi attori a vari livelli, che possano concorrere alla creazione di un quadro normativo adatto a regolare la complessità del ciberspazio, come dimostrato dagli sforzi dell’Unione Europea in materia di protezione dei dati.

L’articolo 17 del GDPR segna un punto di svolta nella protezione dei dati personali nell’Unione Europea, introducendo il “diritto alla cancellazione” dei dati personali, comunemente noto come “diritto all’oblio”. Questo diritto permette agli individui di richiedere la cancellazione dei propri dati personali dal titolare del trattamento senza ingiustificato ritardo, e impone al titolare del trattamento l’obbligo di cancellare tali dati quando sussistono specifiche condizioni.

Nonostante il termine “diritto all’oblio” non sia esplicitamente definito nel GDPR, l’articolo 17 stabilisce chiaramente i presupposti per l’esercizio di questo diritto, tra cui la non necessità dei dati per le finalità originali di raccolta o trattamento, la revoca del consenso da parte dell’interessato, e il trattamento illecito dei dati. Tuttavia, il regolamento ammette eccezioni al diritto alla cancellazione, ad esempio quando il trattamento è necessario per l’esercizio della libertà di espressione e di informazione, per l’adempimento di un obbligo legale, o per motivi di interesse pubblico.

La giurisprudenza e la dottrina hanno sollevato criticità riguardo all’assenza di una definizione precisa del diritto all’oblio e alla discrezionalità affidata alle corti e alle autorità nazionali nel bilanciamento tra i diritti dell’interessato e gli altri interessi in gioco. Inoltre, l’articolo 17 viene interpretato come uno tra i possibili rimedi per realizzare l’oblio, evidenziando come esistano diverse declinazioni di questo diritto, come la deindicizzazione, l’anonimizzazione dei dati, e la contestualizzazione delle informazioni non più attuali.

La giurisprudenza italiana ha affrontato questioni legate al diritto all’oblio, bilanciando il diritto di cronaca e il diritto alla privacy. Due casi significativi riguardano un noto cantautore italiano e una vicenda di uxoricidio, entrambi esemplificativi del dibattito sul diritto all’oblio rispetto alla libertà di espressione e al diritto di cronaca. La Suprema Corte di Cassazione ha delineato criteri per il bilanciamento tra questi diritti, sottolineando che la pubblicazione di informazioni relative a persone a distanza di tempo dai fatti deve rispettare specifici presupposti per non violare il diritto all’oblio.

La decisione delle Sezioni Unite del 2019 rappresenta un momento storico nella giurisprudenza italiana, identificando tre differenti declinazioni del diritto all’oblio e stabilendo che la rievocazione di fatti storici deve avvenire in forma anonima, a meno che non si tratti di figure pubbliche. Questa sentenza evidenzia l’importanza del diritto all’oblio nel contesto digitale, riconoscendo il diritto degli individui a non essere eternamente legati a informazioni del passato, favorendo così la possibilità di reinserimento sociale e la protezione della dignità personale.

La decisione del settembre 2019 della Corte di Giustizia dell’Unione Europea sul caso Google rappresenta un importante punto di riferimento nell’interpretazione e applicazione del diritto alla protezione dei dati personali, in particolare in relazione all’articolo 17 del GDPR. Questa sentenza ha affrontato questioni chiave riguardanti l’ammissibilità dell’esercizio del diritto alla deindicizzazione e la sua possibile estensione territoriale oltre i confini dell’Unione Europea.

La Corte è stata chiamata a risolvere due questioni principali: da un lato, il bilanciamento tra il diritto alla protezione dei dati personali e il diritto all’informazione dell’utente di Internet; dall’altro, la determinazione della portata territoriale del diritto alla deindicizzazione. Con particolare attenzione alla prima questione, è stato riconosciuto che, mentre l’Internet agisce come veicolo per la cura e l’aggiornamento dei dati personali attraverso i siti sorgente e la loro successiva indicizzazione e memorizzazione da parte dei motori di ricerca, l’articolo 17 del GDPR stabilisce le condizioni per cui un individuo può richiedere la cancellazione dei propri dati personali. In questo contesto, è emersa l’importanza non solo del diritto a essere informati ma anche del diritto di informare, sottolineando la necessità di proteggere l’informazione in tutte le sue forme per assicurare il pluralismo informativo e il diritto di ogni utente ad essere adeguatamente informato.

Riguardo alla seconda questione, relativa alla portata territoriale del diritto all’oblio, la Corte ha stabilito che il gestore di un motore di ricerca è tenuto a rimuovere i link dalle versioni del motore di ricerca corrispondenti a tutti gli Stati membri dell’UE, limitando così l’obbligo di deindicizzazione ai confini territoriali dell’Unione. Questa decisione riflette la complessità di estendere la protezione dei dati personali e il diritto alla cancellazione a livello globale, dato che molti paesi al di fuori dell’UE non riconoscono il diritto alla protezione dei dati personali o non lo regolano in modo simile. La sentenza del 2019 chiarisce dunque che la deindicizzazione, sebbene rappresenti un importante strumento di tutela dei diritti degli individui nell’ambito digitale, ha un ambito di applicazione geograficamente limitato all’UE. Questo implica che, nonostante le rigorose protezioni offerte all’interno dell’Unione, la capacità di garantire il diritto alla cancellazione dei dati su scala globale rimane una sfida significativa. La decisione sottolinea l’importanza di sviluppare meccanismi e strategie, come il blocco geografico, che permettano di adempiere efficacemente agli obblighi di deindicizzazione nel rispetto dei principi stabiliti dal GDPR, pur riconoscendo le limitazioni imposte dal contesto normativo e giuridico internazionale.

Forme di tutela

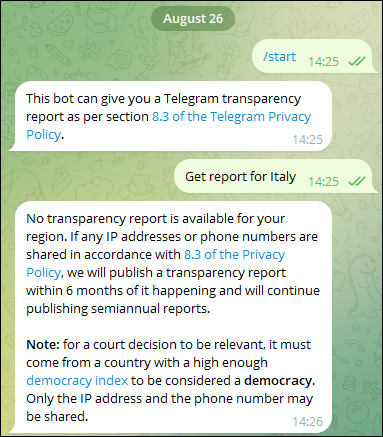

Negli ultimi anni si stanno sviluppando tuttavia altre forme di tutela, le quali demandano l’intera attività di raccolta di informazioni, nonché la fase decisionale, direttamente ai provider o ai soggetti che gestiscono il motore di ricerca. Nei paragrafi successivi saranno analizzati tali strumenti. Sarà altresì preso in considerazione il social network Facebook, il quale, secondo gli analisti anche alla luce della relativa diffusione nel medio e lungo periodo avrebbe l’intenzione di contrapporsi ai motori di ricerca (http://search.fb.com/), integrando un motore di ricerca interno e sfruttando i contenuti dei propri utenti ed avvalendosi di una standardizzazione dei dati particolarmente elevata. Facebook appare certamente così appartenere alla zona grigia della sentenza C-131, in quanto allo stato attuale appare difficile che esso sia considerato come un vero e proprio motore di ricerca, ma inizia già ora a svolgere, in tutto o in parte, la funzione tecnologica di ricerca delle informazioni, seppure in una rete ristretta.

La tematica della deindicizzazione e del diritto all’oblio su internet ha acquisito rilevanza crescente nell’era digitale, particolarmente con l’introduzione di meccanismi che permettono agli individui di richiedere la rimozione di contenuti dai motori di ricerca come Google. Questo fenomeno, evidenziato dalla rapida escalation delle richieste di rimozione subito dopo la disponibilità di un modulo online dedicato, mette in luce le sfide e le complessità intrinseche alla gestione del diritto alla privacy nell’ambiente online.

Google law: un form per l’esercizio dell’oblio

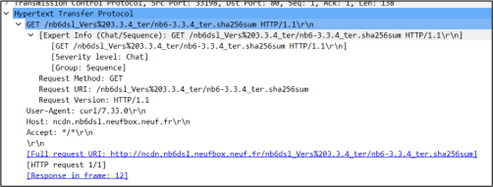

Google, in risposta alle esigenze normative e sociali, ha introdotto un modulo web[1] che consente agli individui di esercitare il diritto all’oblio, chiedendo la rimozione di specifici contenuti dalle pagine dei risultati di ricerca (SERP[2]). L’iter procedurale, nonostante la sua apparente semplicità, nasconde diverse complessità sia operative che etiche. La necessità di allegare una scansione di un documento d’identità, pur consentendo l’anonimizzazione di alcune parti, solleva questioni relative alla sicurezza dei dati personali e alla loro gestione da parte di un ente privato come Google.

La gestione delle richieste, affidata inizialmente al personale junior e poi, in casi più complessi, a consulenti senior e avvocati, denota un processo decisionale strutturato e mirato a valutare l’appropriatezza delle richieste di rimozione. Questo processo si articola in diverse fasi che includono la verifica dell’identità del richiedente, il collegamento con un Paese europeo, la pertinenza delle informazioni con il nome del richiedente e l’interesse pubblico delle informazioni richieste per la deindicizzazione.

Una delle criticità maggiori del sistema di deindicizzazione risiede nella sua applicabilità e conformità alle normative sui diritti alla privacy, in particolare rispetto al contesto europeo. La procedura di Google, pur essendo un passo verso il riconoscimento del diritto all’oblio, sembra limitare la sua applicazione ai cittadini o residenti europei, non allineandosi completamente alle disposizioni del codice della privacy italiano che estende la tutela dei dati personali a chiunque, indipendentemente dalla cittadinanza, purché il trattamento dei dati avvenga sul territorio italiano.

Inoltre, l’efficacia della deindicizzazione si limita alla rimozione dei contenuti basati su specifiche parole chiave, come il nome dell’interessato, senza impedire la reperibilità delle informazioni attraverso altre vie di ricerca. Questo limita sostanzialmente il diritto all’oblio, riducendolo a una mera deindicizzazione nominativa che non cancella la presenza online delle informazioni, ma ne riduce solo parzialmente l’accessibilità.

La gestione del diritto all’oblio da parte di Google pone in evidenza la necessità di un approccio più olistico e conforme alle diverse normative nazionali ed europee. Un sistema efficace di deindicizzazione dovrebbe non solo considerare le specificità legali di ogni Paese ma anche garantire una reale protezione del diritto alla privacy, estendendo la possibilità di rimozione a tutte le informazioni irrilevanti o obsolete, indipendentemente dalle parole chiave utilizzate nella ricerca.

In conclusione, mentre la procedura attuale rappresenta un importante passo avanti nella tutela della privacy online, rimangono significative sfide e opportunità per migliorare l’efficacia e la conformità del diritto all’oblio con le diverse normative sulla protezione dei dati. Sarà fondamentale continuare a monitorare e valutare l’evoluzione di queste pratiche per garantire un equilibrio tra il diritto alla privacy degli individui e l’interesse pubblico all’accesso alle informazioni.

Bing

Bing, il motore di ricerca di Microsoft Corporation, ha reso disponibile un proprio form[3] articolato in 4 parti, per richiedere la deindicizzazione dei contenuti.

Il modo in cui Bing gestisce le richieste di deindicizzazione offre spunti peculiari per un’analisi approfondita, soprattutto se confrontato con Google. Il form di richiesta di deindicizzazione proposto da Bing si distingue per il suo approccio analitico, richiedendo agli utenti di specificare non solo il contenuto da rimuovere ma anche il contesto e la posizione dell’interessato nella propria comunità. Questo dettaglio assume particolare rilevanza in quanto sottolinea l’importanza dell’impatto sociale e comunitario nell’analisi delle richieste, offrendo una tutela più affine alle dinamiche sociali reali.

Differenze significative emergono anche nella territorialità applicata alla procedura di deindicizzazione, con Google che estende la protezione non solo ai residenti ma anche agli individui domiciliati in Europa. Questa estensione rappresenta una sensibilità più ampia verso il diritto alla privacy, andando oltre le mere distinzioni legali tra residenza e domicilio.

Una peculiarità di Bing è la considerazione dello pseudonimo, allineandosi così alle tutele previste dal codice della privacy e dal diritto civile italiano. Questo aspetto è fondamentale in quanto riconosce l’importanza dell’identità digitale e la necessità di proteggerla con le stesse garanzie dell’identità anagrafica.

Per quanto riguarda i minori, Bing adotta una posizione progressista permettendo loro di inviare autonomamente il modulo di richiesta di deindicizzazione. Sebbene questa scelta rispecchi un riconoscimento del diritto al libero sviluppo della personalità del minore, solleva questioni delicate relative alla capacità dei minori di comprendere appieno le implicazioni del consenso al trattamento dei dati e dell’esercizio del diritto alla privacy. La decisione di Bing di consentire tale autonomia merita quindi un’analisi critica, considerando le diverse interpretazioni e le possibili implicazioni legali e sociali.

Inoltre, Bing esige che le richieste di deindicizzazione siano accompagnate da una descrizione dettagliata del contenuto e dalle motivazioni che sottendono alla richiesta. Tale processo riflette un tentativo di bilanciare il diritto all’oblio con la libertà di espressione e l’interesse pubblico all’accesso alle informazioni. Tuttavia, la categorizzazione delle ragioni per la richiesta di rimozione (informazioni inesatte, false, incomplete, inadeguate, non aggiornate, non pertinenti, eccessive o improprie) potrebbe introdurre ambiguità, in quanto confonde il diritto all’oblio con il diritto all’aggiornamento dei dati personali.

Yahoo!

Yahoo! ha predisposto un apposito form “Richieste di Blocco dei risultati della ricerca in Yahoo Ricerca:Risorse per i Residenti in Europa”[4]. In particolare il motore di ricerca specifica che la Corte di giustizia dell’Unione europea ha decretato che gli utenti residenti in Europa possono richiedere che URL specifici vengano deindicizzati rispetto a ricerche specifiche del loro nome, nel caso in cui la pagina contenga dati personali imprecisi, inadeguati, non più pertinenti o eccessivi, relativamente ai fini per i quali erano stati raccolti o elaborati. Gli utenti di Yahoo residenti in Europa possono utilizzare questo modulo per richiedere che un URL venga bloccato per una pagina, associata al loro nome, che rispetti questi criteri. Si ricorda che qualsiasi blocco verrà garantito solamente riguardo alla ricerca del nome specifico dell’utente in questione.

Libero search (Arianna) e gli altri motori italiani

Nel panorama dei motori di ricerca italiani, Arianna (Libero.it) emerge come un caso emblematico. Originariamente lanciato nel 1996 da ricercatori dell’Università di Pisa, Arianna ha modificato la sua strategia nel 2008 adottando i risultati di ricerca forniti da Google Inc., come indicato dalla dicitura “enhanced by Google” sul proprio box di ricerca. Questa scelta rispecchia un adattamento alle branding guidelines di Google, ma solleva questioni riguardanti l’autonomia e la gestione dei dati personali.

Una caratteristica distintiva di Arianna è l’offerta limitata alle funzioni di “ricerca correlata” ed “avanzata”, che mirano a migliorare l’esperienza dell’utente senza stravolgere la SERP (Search Engine Results Page) fornita da Google. Ciò solleva interrogativi sull’esercizio del diritto all’oblio da parte degli utenti italiani, dato che non sono presenti moduli specifici per la deindicizzazione dei contenuti o indicazioni chiare su come la rimozione dei dati da Google possa influire sui risultati di Arianna.

Contrastando con queste realtà, Istella[5] rappresenta un’iniziativa nata dalla collaborazione tra Tiscali, l’Università degli Studi di Pisa e il CNR. Lanciato il 19 marzo 2013, Istella si propone non come un diretto concorrente dei giganti della ricerca online, ma come un’alternativa focalizzata su fonti non indicizzate da altri motori. Nonostante l’approccio innovativo e la non conservazione dei dati degli utenti, anche Istella non fornisce indicazioni chiare sull’esercizio del diritto all’oblio. Rimane presente unicamente una informativa privacy[6] che non contiene alcuna informazione in merito all’esercizio di questo specifico diritto.

La questione del diritto all’oblio nei motori di ricerca italiani riflette la complessità delle interazioni tra normative sulla privacy, gestione dei dati personali e le tecnologie sottostanti. Mentre Arianna e Excite Italia mostrano le sfide poste dall’integrazione con tecnologie esterne, Istella offre una visione alternativa che tuttavia non chiarisce pienamente come viene gestito il diritto all’oblio. Questo panorama sottolinea la necessità di un quadro normativo e di pratiche aziendali che garantiscano trasparenza e controllo effettivo agli utenti sui loro dati personali nel contesto digitale.

Facebook (Meta) e gli altri social network

L’intersezione tra il diritto all’oblio e le piattaforme di social media, come Facebook, Twitter e LinkedIn, pone sfide uniche e complesse, che riflettono le tensioni tra privacy individuale, libertà di espressione e i confini della regolamentazione legale. La gestione dei dati personali e l’applicabilità del diritto all’oblio su queste piattaforme diventa particolarmente problematica alla luce delle diverse interpretazioni normative e delle politiche aziendali.

Le piattaforme social come Facebook, Twitter e LinkedIn hanno trasformato il modo in cui interagiamo, comunicando e condividendo informazioni su scala globale. Tuttavia, la persistenza digitale delle informazioni condivise online solleva questioni rilevanti riguardo al diritto all’oblio, un principio che mira a consentire agli individui di richiedere la rimozione di informazioni obsolete o irrilevanti su di loro da risultati di ricerca o database online.

Facebook, in particolare, ha affrontato critiche e sfide legali in Europa per il suo approccio alla privacy e alla gestione dei dati personali. Il conflitto con il Garante della privacy tedesco riguardante l’estensione del diritto all’oblio ai contenuti presenti sul social network sottolinea la difficoltà di definire i confini di applicabilità di questo diritto alle piattaforme di social media. La posizione di Facebook, basata sulla conformità alla normativa irlandese, riflette una strategia di minimizzazione delle responsabilità legali, ma solleva interrogativi sulla sua adeguazione alle esigenze di privacy degli utenti europei.

La legislazione italiana, attraverso l’intervento del Garante Privacy, ha tuttavia evidenziato come la presenza di una struttura organizzativa stabile all’interno del paese (Facebook Italy s.r.l.) imponga l’applicazione del diritto nazionale in materia di protezione dei dati, confermando così l’applicabilità del diritto all’oblio anche ai giganti del web con base in altri paesi dell’UE.

Analogamente, Twitter e LinkedIn presentano le loro politiche in materia di gestione dei dati personali, ma con una meno evidente attenzione al diritto all’oblio. Twitter, ad esempio, ha adottato misure per impedire l’eliminazione dei tweet di figure pubbliche, sottolineando la tensione tra il diritto alla privacy e l’interesse pubblico; tuttavia, il diritto all’oblio su Twitter è meno evidente poiché la piattaforma è più orientata verso il presente e la condivisione immediata di informazioni. LinkedIn, d’altra parte, offre un’informativa sulla privacy[7] dettagliata ma non fornisce indicazioni chiare sulla possibilità di esercitare il diritto all’oblio.

La questione del diritto all’oblio nei confronti dei social network evidenzia la complessità di applicare principi giuridici stabiliti a realtà tecnologiche e sociali in continua evoluzione. Mentre le piattaforme social si sforzano di bilanciare la protezione della privacy con la libertà di espressione e le esigenze commerciali, la definizione e l’attuazione del diritto all’oblio rimangono una sfida significativa.

Queste dinamiche richiedono un dialogo continuo tra legislatori, piattaforme social e società civile per sviluppare approcci che rispettino i diritti degli individui alla privacy e all’oblio digitale, pur garantendo il libero flusso di informazioni e la trasparenza. In ultima analisi, il diritto all’oblio nei social media solleva questioni fondamentali sulla nostra identità digitale e su come vogliamo che il nostro passato online influenzi il nostro futuro.

In ogni caso, Facebook assicura la possibilità di rimuovere contenuti che non rispettano la dichiarazione dei diritti e delle responsabilità di Facebook[8] – [9] e rinvia alla normativa sull’utilizzo dei dati[10]. È prevista la possibilità di eliminare l’account[11] in qualsiasi momento o, alternativamente, di disattivare l’account in maniera temporanea; questa opzione attribuisce la possibilità di non essere più visibile a sé stessi ed a terzi, ma di poter disporre nuovamente dell’intero complesso di informazioni, che saranno comunque nuovamente accessibili[12]. È previsto uno specifico modulo mediante il quale è possibile segnalare possibili violazioni della propria privacy[13].

Su Facebook, il diritto all’oblio si applica principalmente alle informazioni pubblicate dagli utenti stessi o da terze parti che possono influire sulla loro reputazione, vita personale o professionale. Questo può includere foto, post, commenti o altre informazioni che potrebbero non essere più rilevanti o che possono arrecare danno alla persona nel tempo[14].

… ma in pratica?

Da un punto di vista pratico, bisogna evidenziare che le iniziative proposte dai principali motori di ricerca si sono rilevate nel tempo solo soluzioni di mera facciata più che di sostanza, in quanto:

- “de-indicizzazione” non significa “cancellazione”, cioè Google non potrà mai cancellare la pagina incriminata, ma farà solo in modo (o meglio, promette di fare in modo) di eliminare la possibilità che tale pagina figuri tra i risultati delle ricerche. In pratica, Google de-indicizzando il contenuto fa sì che lo stesso non possa essere “pescato” da chi scrive il nome e cognome dell’interessato sul motore (ma coi limiti, peraltro, che a breve vedremo). È ovvio, invece, che solo la totale cancellazione della pagina può garantire la certezza che l’informazione non venga mai più letta. Il fatto che la stessa continui a esistere nel web non esclude, infatti, la possibilità che essa venga trovata in modi alternativi rispetto alla ricerca su Google: per esempio, attraverso un link presente su un social network o su un’altra pagina di un diverso sito contenente notizia affine e mai de-indicizzata; una ricerca diretta all’interno dell’archivio del giornale online (per esempio, ricercando nel “motore di ricerca interno” al Corriere, Repubblica, ecc.);

- vi è una possibilità di “ripescaggio” della pagina al variare nel tempo degli algoritmi di indicizzazione. Nella causa davanti alla Corte di Giustizia, Google aveva fatto notare la possibilità che, una volta deindicizzata la pagina incriminata, la stessa potrebbe, in teoria, essere sempre ripescata in un momento successivo, dallo stesso “crawler” automatico di Google. Anche in questo caso, se la pagina continua a esistere, nulla toglie che, in futuro, possa rispuntare grazie all’algoritmo di BigG che, ogni giorno, scandaglia le notizie presenti in Rete;

- la sentenza era vincolante di fatto solo nei confronti di Google. Pertanto, ammesso che la notizia venga cancellata da Google, la stessa sarà agevolmente reperibile attraverso altri motori di ricerca (Bing, Yahoo, Virgilio, Tiscali, ecc.);

- l’attuazione della “de-indicizzazione” è subordinata non tanto alla volontà del Giudice, quanto a quella di un soggetto privato (es. Google), ossia a una company che il più delle volte non è assoggettata alla legislazione europea e che fa della circolazione dei contenuti il proprio core business. Tale situazione determina di fatto un’arbitrarietà della scelta da parte dei provider e che quindi funge da deus ex machina nel bilanciamento tra l’interesse legittimo del privato cittadino e le altre motivazioni contrapposte: il diritto di cronaca, l’interesse pubblico alla diffusione della notizia (valutata sulla base dell’indice di lettura della pagina), ecc. ;

- Google ha già fatto sapere tutta una serie di casi nei quali, comunque, non procederà mai alla de-indicizzazione della notizia. Si tratta dei casi in cui la notizia riguarda:

- frodi finanziarie (per es.: l’amministratore di una società colpevole di bancarotta fraudolenta, oppure che ha nascosto gli utili agli azionisti; casi di insider trading, ecc.);

- negligenza professionale (per es.: un medico processato per una morte sospetta; un avvocato che ha perso una causa per un errore grave; un ingegnere che ha costruito un palazzo poi crollato, ecc.);

- condotta pubblica di funzionari statali (per es.: un caso di concussione o di corruzione);

- condanne penali. È proprio questo il punto più dolente: parlare di “condanne penali” (concetto che racchiude già tutti i casi appena elencati) è così generico da ricomprendere quasi tutte le richieste di diritto all’oblio (quasi sempre legate a processi di carattere penale, indagini della magistratura, ecc.). Va da sé che se Google escluderà, a priori, proprio queste istanze, il “modulo automatico” è praticamente inutile.

- la sentenza della Corte di Giustizia si applica solo in Europa e non nel resto del mondo, dove Google potrà continuerà a rendere indicizzato il contenuto. Così, chi comunque faccia la ricerca su Google.com anziché su Google.it o su Google.fr troverà ugualmente la “pagina incriminata”. È anche questa l’ennesima (negativa) conseguenza del fatto che il contenuto incriminato non è stato cancellato ma solo rimosso dalle ricerche;

- l’applicazione del diritto all’oblio in un contesto globale: prendendo ad esempio Facebook sono evidenti le molteplici sfide legate alla natura transnazionale della piattaforma e alla vastità della sua rete utenti, ad esempio:

- diversità di leggi sulla privacy: Facebook opera in numerosi paesi, ognuno con la propria legislazione in materia di protezione dei dati e privacy. Mentre in Europa il GDPR (Regolamento Generale sulla Protezione dei Dati) fornisce una cornice abbastanza omogenea che include il diritto all’oblio, in altre regioni del mondo tale diritto potrebbe non essere riconosciuto o potrebbe essere interpretato in modi diversi. Questo pone la sfida di come applicare coerentemente una politica di privacy su scala globale;

- implementazione tecnica: la struttura tecnologica di Facebook è complessa e altamente distribuita, con server e centri dati dislocati in diverse parti del mondo. Quando un utente richiede la rimozione di contenuti basandosi sul diritto all’oblio, Facebook deve essere in grado di identificare e rimuovere efficacemente tali contenuti in tutte le sue infrastrutture, il che può essere tecnologicamente impegnativo;

- ambito di applicazione territoriale: c’è stata una notevole discussione sui confini territoriali dell’applicazione del diritto all’oblio. Ad esempio, se un utente in Francia chiede la rimozione di un contenuto, Facebook deve rimuovere quel contenuto solo per gli utenti nell’UE o globalmente? Le interpretazioni e le sentenze dei tribunali europei hanno variato nel tempo, aumentando la complessità della conformità.

Marketing

Il GDPR amplia il diritto all’oblio, comunemente associato al diritto di interrompere la diffusione di private informazioni, alla sfera dei dati con finalità di marketing. Come già affrontato fin qui, la cancellazione di dati personali è solitamente volta ad impedire l’espansione di informazioni obsolete e nocive per la propria nomea.

Allargando tale concetto al contesto di marketing, anche qui il GDPR attribuisce all’utente, la facoltà di cancellazione dei propri dati sensibili, qualora questi non siano stati cancellati autonomamente alla cessazione dei termini per cui essi sono stati acquisiti. Qualora infatti dati acquisiti con finalità di marketing, fossero ancora presenti al termine del loro reale scopo per cui sono stati acquisiti, l’interessato potrà fare richiesta di cancellazione degli stessi senza la necessità di fornire valide motivazioni. Ulteriormente, tale diritto si applica anche qualora i dati siano stati acquisiti in modo illecito senza il consenso dell’interessato. Pertanto allorché quest’ultimo ne venisse a conoscenza, può far valere il diritto all’oblio e i propri dati dovranno essere eliminati, onde evitare sanzioni da parte dell’autorità garante, in quanto il loro trattamento non è conforme al GDPR.

Ma allora: è possibile un diritto all’oblio in ambito digitale?

La riflessione sulla natura e l’applicazione del diritto all’oblio nel contesto digitale apre un dibattito complesso e articolato che interroga direttamente i limiti delle tecnologie attuali e le loro implicazioni etiche e giuridiche. La questione centrale riguarda la possibilità di controllare e, in certi casi, limitare la persistenza delle informazioni personali nell’ecosistema digitale, in particolare nei motori di ricerca e nelle SERP (Search Engine Results Pages).

Il diritto all’oblio è stato interpretato come la capacità di influenzare l’accessibilità delle informazioni digitali, volto a rendere più difficile il recupero di specifici dati personali, con l’obiettivo ultimo di preservare l’autonomia dell’individuo sulla propria identità digitale. Tale concetto si scontra però con la natura intrinsecamente transattiva e distribuita della memoria digitale, che fonde insieme capacità computazionali e interazioni umane in un processo di memorizzazione unificato e di difficile regolamentazione.

Una possibile via d’uscita potrebbe consistere nell’adottare una concezione di “pseudo-deindicizzazione”, analogamente alla distinzione tra pseudo-anonimizzazione e anonimizzazione, che contempli diritti come la rettifica, l’aggiornamento e la cancellazione dei dati in modo più specifico e operativo.

L’idea di un diritto all’Habeas SERP, ossia il controllo individuale sui risultati di ricerca legati al proprio nome, solleva questioni critiche relative alla libertà di espressione e al diritto di cronaca, ponendo l’identità digitale in una posizione potenzialmente predominante rispetto ad altri diritti fondamentali.

La proposta di rendere pubblici gli algoritmi di ricerca potrebbe democratizzare l’accesso a tecniche di ottimizzazione SEO, ma comporterebbe al contempo rischi di manipolazione informativa e alterazioni degli equilibri di mercato, soprattutto per quanto riguarda i motori di ricerca dominanti. In definitiva, qualsiasi tentativo di normare il diritto all’oblio digitale richiederebbe un accordo internazionale, per evitare disparità di trattamento e digital divide. Tuttavia, l’adeguamento sociale e tecnologico all’evoluzione della memoria digitale potrebbe offrire un terreno fertile per nuove soluzioni che bilancino privacy, diritto all’informazione e libertà di espressione.

Conclusione

Già dagli anni 2000, il Garante italiano per la protezione dei dati personali ha affrontato la questione della “gogna elettronica”, sottolineando la necessità di un diritto all’oblio che consentisse agli individui di richiedere la rimozione di notizie online non più attuali o rilevanti. Questa preoccupazione ha portato alla richiesta ai motori di ricerca di aggiornare periodicamente i dati online per riflettere situazioni attuali, sottolineando l’importanza dell’accuratezza e della pertinenza delle informazioni disponibili sul web.

Con provvedimenti successivi, l’Autorità Garante ha ribadito l’importanza dell’aggiornamento degli archivi giornalistici online, offrendo la possibilità di aggiungere note o link che forniscano contesto aggiuntivo, garantendo così una rappresentazione completa e aggiornata delle notizie riguardanti individui specifici.

L’intervento del Garante nel 2019, in relazione a una richiesta di cancellazione di articoli giudiziari, ha sottolineato il delicato bilanciamento tra il diritto alla privacy e la libertà di cronaca. L’Autorità ha riconosciuto la legittimità del trattamento dei dati personali per finalità giornalistiche, anche senza il consenso degli interessati, a condizione che tale trattamento rispetti la libertà e la dignità dell’individuo e si basi su fatti di rilevanza pubblica. In questo caso, l’interesse pubblico prevaleva sulla richiesta di esercizio del diritto all’oblio, data la rilevanza della vicenda giudiziaria e il ruolo pubblico di uno dei soggetti coinvolti.

La “riforma Cartabia” del 2021 rappresenta un ulteriore passo avanti, delegando il governo a regolamentare la deindicizzazione di dati personali in caso di archiviazione o assoluzione in procedimenti giudiziari, rafforzando così il diritto all’oblio degli individui coinvolti in indagini o processi. Questa legislazione stabilisce criteri specifici per garantire la rimozione efficace di informazioni obsolete o non più rilevanti dai motori di ricerca, sottolineando l’importanza di una pronta reazione in caso di mancato adempimento.

Queste evoluzioni normative e giurisprudenziali evidenziano la crescente consapevolezza della necessità di bilanciare la libertà dell’informazione con i diritti fondamentali degli individui nell’era digitale. Tuttavia, la rapidità dell’innovazione tecnologica e la sua influenza sulla diffusione delle informazioni sollevano questioni complesse relative alla regolamentazione dell’informazione online. La definizione di una “etica del cybernauta” e l’elaborazione di principi per una “cittadinanza digitale” responsabile sono fondamentali per garantire che la libertà di espressione non diventi un veicolo per l’offesa o la diffamazione, sottolineando la necessità di un equilibrio tra i diritti individuali e l’accesso pubblico all’informazione in un contesto sempre più dominato da realtà virtuali e piattaforme digitali.

Nel contesto della “società digitale”, dove le informazioni sono facilmente registrate, archiviate e accessibili online, il diritto all’oblio è diventato un tema centrale nei dibattiti sulla privacy e sulla gestione delle informazioni personali. Le persone possono essere danneggiate o discriminate a causa di informazioni obsolete o imprecise che rimangono online e il diritto all’oblio può offrire una forma di protezione in questi casi.

Tuttavia, implementare effettivamente il diritto all’oblio è complicato, poiché coinvolge un delicato equilibrio tra la protezione della privacy individuale e la libertà di informazione. Le piattaforme online devono trovare modi per rispettare le richieste di rimozione delle informazioni senza compromettere la disponibilità di informazioni legittime e importanti.

In definitiva, il diritto all’oblio rappresenta una sfida importante per la società digitale, poiché cerca di trovare un equilibrio tra la protezione della privacy individuale e la libertà di informazione in un ambiente online in continua evoluzione.

La complessa relazione tra la tutela del diritto all’oblio nell’era digitale e la natura globale della rete Internet solleva questioni significative circa l’efficacia e l’applicabilità della legislazione in materia di protezione dei dati personali, come dimostrato dal GDPR e dalla giurisprudenza relativa. Il caso Google del 2019 presso la Corte di giustizia dell’Unione Europea ha messo in evidenza i limiti territoriali del diritto all’oblio, stabilendo che la deindicizzazione dei dati personali richiesta in base all’articolo 17 del GDPR debba essere attuata solo all’interno dell’Unione Europea, senza imporre obblighi di cancellazione globale ai gestori dei motori di ricerca.

Questa decisione sottolinea l’inadeguatezza di un quadro normativo che non contempla un’effettiva tutela dell’oblio su scala mondiale, evidenziando le difficoltà nell’armonizzare la protezione dei dati personali con il carattere intrinsecamente senza confini della rete. Sebbene il GDPR rappresenti un avanzamento significativo nella protezione dei diritti degli individui nell’ambito digitale, la sua portata limitata territorialmente lascia aperte questioni relative alla gestione dei dati personali su piattaforme accessibili globalmente. In conclusione, la tutela dell’oblio in Internet rimane un ambito di notevole complessità, dove le normative esistenti si scontrano con la natura decentralizzata e globale della rete. La ricerca di un equilibrio tra la dignità della persona e la libertà di espressione si manifesta come una sfida continua, resa ancora più ardua dai rapidi sviluppi tecnologici. Il dibattito sull’adeguatezza delle normative in questo contesto è aperto, richiedendo agli interpreti un costante sforzo ermeneutico per navigare tra le incertezze disciplinari e le dinamiche in evoluzione del mondo digitale. In questo scenario, l’imperativo di trovare soluzioni che riflettano i valori fondamentali della società nell’era dell’informazione si affianca alla consapevolezza che soluzioni universalmente applicabili possono essere difficili, se non impossibili, da realizzare in un ambiente caratterizzato da un “algoritmo sovrano” che continua a ridefinire le modalità di interazione e di espressione nell’ambito virtuale.

[1] https://reportcontent.google.com/forms/rtbf

[2] La locuzione inglese Search Engine Results Page, più semplicemente “SERP”, indica comunemente la pagina dei risultati di un motore di ricerca.

[3] https://www.bing.com/webmaster/tools/eu-privacy-request

[4] https://io.help.yahoo.com/contact/index?page=contactform&locale=it_IT&token=Zh%2FBBVqXzLHlIbokbUqVWTUbuuQeXGkGzJ%2FxkLsJP07Zgk%2B%2B1eFwBr5d5R9oF0htO%2BBvaT6%2BQLZMo4%2BSEICbjKW0zsv%2BqoEY6hjokP5ca3%2FIpyH1fp5qSukQCRifkLYrh8vWbODAAU3Jgf9Mu86t7Q%3D%3D&selectedChannel=email-icon&yid=

[5] www.istella.it

[6] https://www.istella.it/it/privacy

[7] https://www.linkedin.com/help/linkedin/topic/a65?trk=hc-hp-recommendedTopics

[8] https://it-it.facebook.com/legal/terms/previous

[9] https://www.facebook.com/legal/terms/update?ref=old_policy

[10] https://www.facebook.com/privacy/policy/?entry_point=data_policy_redirect&entry=0

[11] https://www.facebook.com/help/125338004213029

[12] In caso di eliminazione permanente dell’account, Facebook. garantisce l’eliminazione di tutti i contenuti, anche quelli memorizzati sui propri sistemi di backup, entro novanta giorni successivi alla relativa richiesta, ad eccezione di alcuni contenuti al cui presenza sia reputata necessaria per motivi tecnici. Alcune informazioni rimarranno tuttavia ancora presenti nei sistemi di Facebook Inc. nonostante l’eliminazione.

[13] https://www.facebook.com/help/contact/144059062408922

[14] https://www.facebook.com/help/contact/319149701968527

Bibliografia

ASSONIME – Associazione fra le società italiane per azioni. “Diritto all’oblio e deindicizzazione dai motori di ricerca: la giurisprudenza della Corte di giustizia”. Note e Studi 1/2020.

Direzione della Comunicazione Unità Stampa e informazione. Comunicato stampa n. 197/22. Lussemburgo, 8 dicembre 2022. Sentenza della Corte nella causa C-460/20 | Google (Deindicizzazione di contenuti asseritamente inesatti). “Diritto alla cancellazione («diritto all’oblio»): il gestore di un motore di ricerca deve deindicizzare le informazioni incluse nel contenuto indicizzato quando il richiedente dimostri che sono manifestamente inesatte”.

EDPB – European Data Protection Board. “Linee guida 5/2019 sui criteri per l’esercizio del diritto all’oblio nel caso dei motori di ricerca, ai sensi del RGPD” (parte 1 – versione 2.0, adottate il 7 luglio 2020.

GPDP – Garante per la Protezione dei Dati Personali. “Diritto all’oblio”. https://www.garanteprivacy.it/i-miei-diritti/diritti/oblio.

Agostini A., De Nardis A., La tua reputazione su Google ei social media: prevenire, monitorare, curare, Hoepli, Milano, 2013.

Alpa G., Resta G., “Le persone e la famiglia. Le persone fisiche e i diritti della personalità”, in Trattato di diritto civile, 2006

Ambrose M. L., Ausloos J., “The right to be forgotten across the pond”, in Journal of Information Policy, 2013.

Arieta G., “Una nuova impostazione dei rapporti tra informazione e tutela della vita privata?”, in Temi.

Ausloos J., “The Right to be Forgotten – Worth remembering?”, in Computer Law and Security Review, 2012.

Barchiesi A., “La tentazione dell’oblio. Vuoi subire o costruire la tua identità digitale?”, Franco Angeli, Milano, 2016.

Bartolini C., Siry L., “The right to be forgotten in the light of the consent of the data subject”, in Computer Law and Security Review, 2016.

Bassoli E., “Come difendersi dalla violazione dei dati su Internet. Diritti e responsabilità”, Maggioli Editore, Rimini, 2012.

Bitetto A., “Cronaca, oblio e memoria: prospettive comparate tra riservatezza e identità”. Dipartimento Jonico in Sistemi Giuridici ed Economici del Mediterraneo: Società, Ambiente, Culture. Quaderni del Dipartimento Jonico, 21/2023.

Ciani Sciolla J., “Diritto all’oblio e cooperazione internazionale: problemi e prospettive”, Rivista Italiana di Informatica e Diritto. Periodico Internazionale e del CNR-IGSG, fascicolo 1-2022.

Di Ciommo F., “Diritto all’oblio. Quello che il diritto non dice. Internet e oblio”. Da Opinioni Libere professioni. Danno e responsabilità.

Di Ciommo F., “Il diritto all’oblio (oblito) nel regolamento Ue 2016/679 sul trattamento dei dati personali”. Il Foro Italiano, V 6 fasc. 9/2017.

Finocchiaro G., “Il diritto all’oblio nel quadro dei diritti della personalità”. Il diritto dell’informazione e dell’informatica, Anno XXIX Fasc.4-5 – 2014.

Leucci S., “Diritto all’oblio, verità, design tecnologico: una prospettiva di ricerca Right to Be Forgotten, Truth and Technological Design”, Media Laws – Rivista di diritto dei media, Saggi – Sezione Monografica “fake news, pluralismo informativo e responsabilità in rete” Articles – Fake News, Pluralism and ISP Liability.

Ligresti A., “Il diritto all’oblio nella “rete” senza regole”, Amministrazione In Cammino, Rivista elettronica di diritto pubblico, di diritto dell’economia e di sicurezza e di scienza dell’amministrazione, 2022.

Martinelli S., “Diritto all’oblio e motori di ricerca. Memoria e privacy nell’era digitale”. Informatica Giuridica – Collana diretta da Giovanni Ziccardi e Pierluigi Perri. Estratto_024198827.

Messina D., “Le prospettive del diritto all’oblio nella società dell’informazione e della comunicazione”. Informatica e diritto, XXXV annata, Vol. XVIII, 2009.

Pardolesi R., “L’ombra del tempo e (il diritto al)l’oblio”. Obiettivo 1. Il diritto di crono. Questione Giustizia 1/2017.

Pisapia M, Cherchi C., “Diritto all’oblio. Prime riflessioni sull’introduzione dell’art. 64-ter disp. att. c.p.p.”. Media Laws – Rivista di diritto dei media, cronache 02/2023.

Tullio L., “Tracce evolutive del «right to be forgotten» tra esigenze di anonimato e richieste di deindicizzazione”, Ianus Rivista di Studi Giuridici n.22 – dicembre 2020.

Vesto A. “La tutela dell’oblio tra intimità e condivisione senza filtri”, Media Laws – Rivista di diritto dei media. 2/2018. Zanichelli M. “Il diritto all’oblio tra privacy e identità digitale”. Informatica e diritto, XLII annata, Vol. XXV, 2016.